Publicado por Equipo GNOSS

07/05/2019

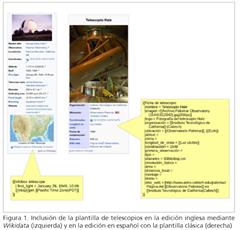

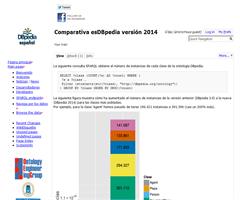

"A partir de Wikipedia, como fuente de conocimiento organizado en forma de artículos enciclopédicos, editada mediante la colaboración masiva online, se han desarrollado dos proyectos de carácter semántico: DBpedia y Wikidata. Se analizan las diferencias y similitudes entre ambos modelos de datos y modelo de producción, y se especula sobre la posible evolución y coexistencia de ambos a partir de sus puntos fuertes. Su fortaleza como grafo abierto de conocimiento multidominio aporta un gran valor a la extensión de la web de datos, al actuar como punto de interconexión entre diferentes dominios".

Saorín, Tomás; Pastor-Sánchez, Juan-Antonio (2018). “Wikidata y DBpedia: viaje al centro de l...